Apuntes Curso Redes de Computadoras

Se toman apuntes de clases y el libro de Kurose: Computer Networking: A top-down approach.

Parte I - Computer Networks and the Internet

Que es la internet?

Podemos responderla de dos formas: Por los componentes físicos que la integran o en términos de una infraestructura de conexión que provee servicios a aplicaciones distribuidas.

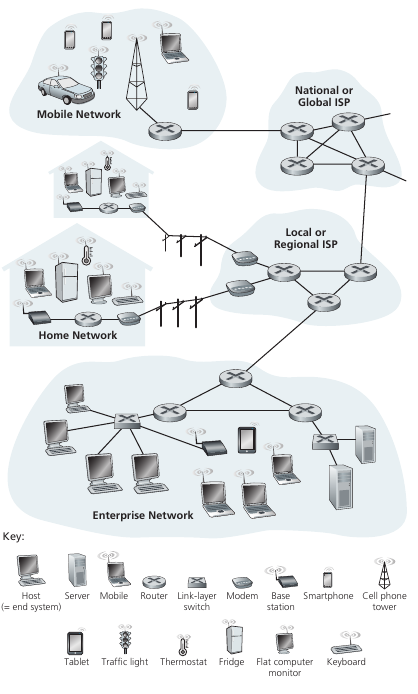

Visión física

La internet esta formada por hosts or ends systems que se encuentran inter-conectados por communication links y packet switches. Los communication links pueden ser de muchos tipos (coaxial, cobre, fibra, etc) los cuales tienen sus características particulares. Cuando un host tiene que enviar información, la segmenta y le agrega headers con información. A estos segmentos se les llaman paquetes y son las unidades que viajan por la red. El sistema que recibe todos los paquetes los vuelve a ensamblar para obtener los datos originales. Los packet switches toman un paquete que llega desde una de sus entradas de comunicación y la reenvia por otra de sus salidas de comunicación. Existen muchos tipos de switches, los más predominantes son los routers y link-layer switches. La secuencia de communication links y packet switches por los que pasa un paquete por la red se le llama route/path.

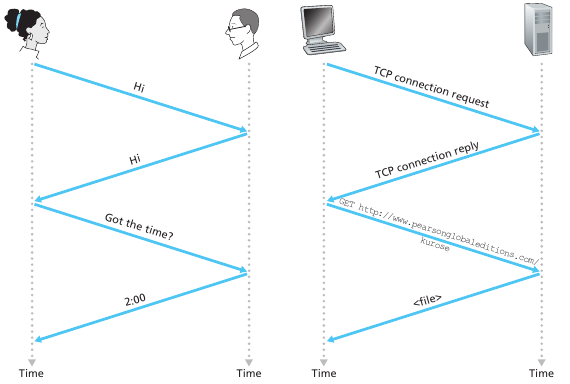

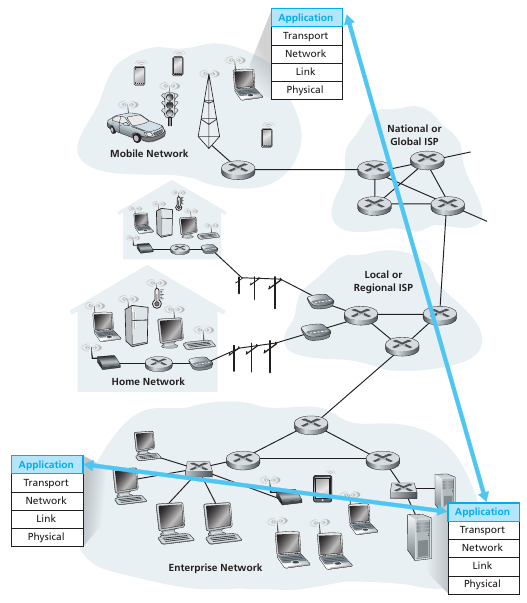

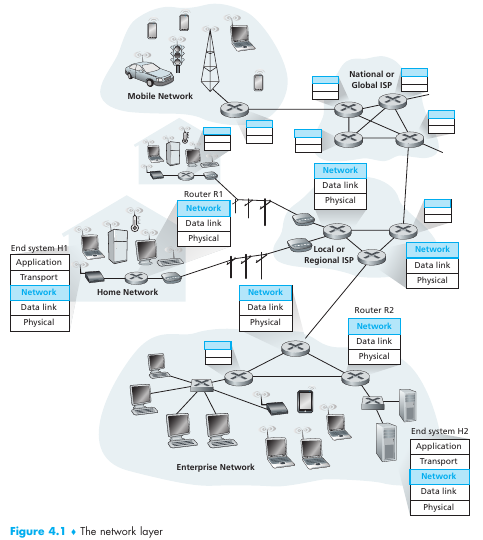

Los sistemas finales acceden a la internet a través de internet service providers (ISP), cada ISP es en sí una red de packet switches y comm links. Todos los dispositivos obedecen un protocolo para poder inter-comunicarse entre sí: Estos son el transmission control protocol (TCP) y el Internet Protocol (IP). El IP especifica el formato de los paquetes. A estos dos se les llama TCP/IP. Estos son regulados por agencias de standardization (IEEE & Engineering task force (Con sus requests for comments (RFC))). Algunos ejemplos de RFC's son: TCP,IP,HTTP,SMTP, hay más de 7000... La IEEE establece los protocolos LAN/MAN, Ethernet y WiFi. Un protocolo define el formato y orden de un intercambio de mensajes entre dos entidades así como las acciones tomadas por la transmission y/o recibo de un mensaje o otro evento.

Visión de servicios

La internet es una infraestructura que provee servicios a las aplicaciones. Las aplicaciones que usan estos servicios se les llama distributed applications, ya que reciben/envían datos de muchas partes. Las aplicaciones de internet corren en los hosts y son para los hosts. Los sistemas conectados a internet proveen una socket interface que especifica como un programa que corre en un host le pide a la internet para enviar datos a un programa que corre en otro host. Existe un conjunto de reglas e interfaces que el programa debe seguir para lograr la comunicación.

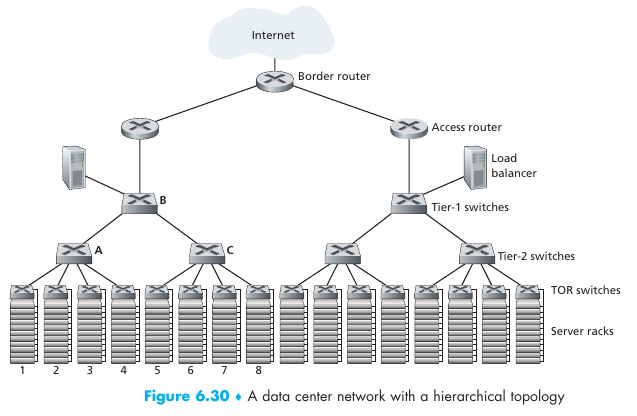

El borde de la red

Los hosts son quientes se encuentran en el borde de la red, por ello se les dice sistemas finales. A su vez, puede aveces dividirse los hosts en dos subsets: clientes y servidores. Un cliente es un celular o una pc de una persona normal, mientras que un servidor es una computadora mas potente que hostea paginas web, videos y servicios. Los grandes lugares donde se almacenan videos y contenido se les llama data centers.

Redes de acceso

Los comm links que conectan los sistemas finales al "interior de la red" a través del primer router (edge router) son el primer enlace que conecta un host con la internet. Existen distintos tipos y clases y tecnologías de acceso.

Tecnología de los comm links

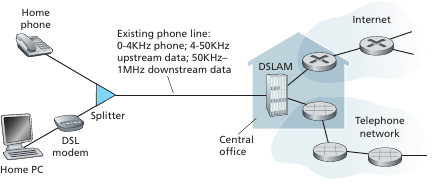

Para las residencias, existe el DSL,Cable,FTTH,Dial-Up y Satellite. El Digital subscriber line (DSL) es el que comprate la conexión con la red telefonica. Se transportan los datos en diferentes frecuencias de subida/bajada de internet y la red telefonica permitiendo enviar todo en simultaneo. El Digital subscriber line access multiplexer (DSLAM) se encarga de multiplexar los canales y enviarlos al corazón de la web y a las centrales telefónicas respectivamente. El rango de frecuencias para subida y bajada son distintos, dando valores distintos de velocidad, por ello se dice que la red es asimétrica y a su vez la ISP puede topear los valores según cuanto pagas. Los transmission rates también se ven topeados por la distancia, interferencia eléctrica y grosor del cable (twisted pair).

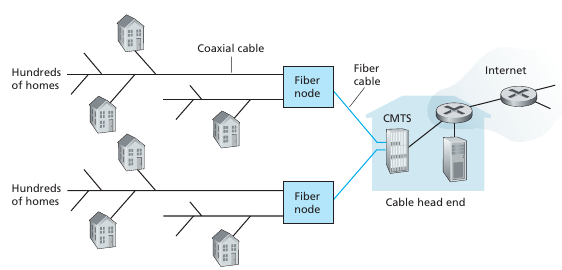

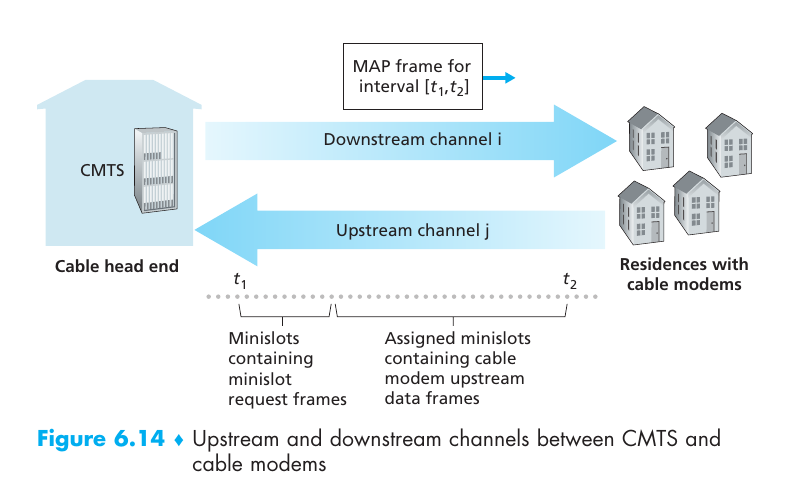

Por otro lado, el cable usa la infraestructura de la red de televisión. Se puede combinar con fibra óptica, lo que se le llama hybrid fiber coax (HFC). Cada medio requiere un modem especial para transformar la señal digital de ethernet a la del medio (cable/dsl modem). La unión entre el cable y el modem se le llama cable modem termination system (CMTS) y cumple una función similar al DSLAM que es la transformación de señales según el medio. Notar que la internet por cable estaba pensada para el broadcast, por el cable se recibe las señales de todos los usuarios y el modem tiene que pickear las que son para el.

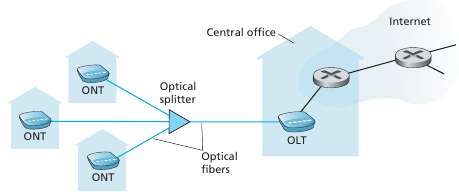

Países avanzados como uruguay utilizan fibra óptica, a esto se le llama FTTH (Fiber to the home). Por lo general tenemos un cable de fibra que es usado por muchos usuarios y a medida que nos vamos acercando cada usuario tiene un cable individual. Existen dos arquitecturas para diseñar la red de fibra: passive optical network (PON) y active optical network (AON).

El dial-up era la tech que utilizaba literalmente la red telefonica, no permitiendo usar el teléfono a la vez y era super lenta. Para lugares remotos se puede usar la conexión satelital, esta por temas de distancia tiene importantes desventajas.

Dentro de lo que se denomina la red local (LAN), los sistemas utilizan ethernet para conectarse al switch. Se utiliza un twisted pair copper wire. Luego este switch se conecta al router que provee conexión con la ISP. Otro método popular es el Wireless LAN (WiFi). Las redes móviles como el 3G y el LTE son también usadas para acceder a la red.

Medios físicos

Es el medio por donde los bits llegan de un receptor a otro. Existen dos grandes categorías: medios guiados y no guiados los guiados son los que pasan por un medio solido, como un cable de cobre. Y los no guiados son los que se transportan por la atmósfera y el espacio como ondas electromagnéticas (wifi).

#l par trenzado de cobre, se trenza para reducir la interferencia (cada cable de 1mm de grosor esta insulado) El par de cables constituye un communication link. Unshielded twisted pair UTP es el más utilizado para conectar computadoras. El cable coaxial consiste en dos conductores concéntricos con insulación y protección. La fibra óptica transmite pulsos de luz, son inmunes a la frecuencia electromagnética aunque son algo frágiles. En el corazón de la red se usa este medio, no es tan predominante en las redes de hogar por el alto costo de los dispositivos. Luego están los medios de radio como el wifi y los satelitales. Existen dos tipos de satélites: los geoestacionarios y los de LEO (low-earth-orbiting). Los geoestacionarios están a 36000 km de la superficie para igualar la velocidad de rotación de la tierra, tienen como 280ms xd. LEO están más cerca de la tierra y no se mantienen quietos, rotan sobre la misma y se comunican entre otros satélites y estaciones en la tierra. Para proveer comunicación continua tiene que haber muchos satélites LEO conectados y un meticuloso calculo de órbitas.

El corazón de la red

Packet switching

Para enviar paquetes de un host a otro, los paquetes recorren un path de comm links y packet switches (routers and link-layer switches). Los paquetes se transmiten por cada comm link a una tasa igual a la full transmission rate del link. Es decir, si se mandan $L \ bits$ por un link con tasa de transmisión $R \ bits/sec$, el tiempo de transmisión del paquete será $ \frac{L}{R} $ segundos. La mayoría de packet switches usan store-and-forward transmission en las inputs de los links. Estos es, los packet switches tienen que recibir,almacenar y procesar todos los bits de una paquete antes de poder reenviarlo a otra entrada. Debido a esto el delay de envíar un paquete de L bits con un path de N links con rate R (N-1 packet switches) es $ d_{end-to-end} = N\frac{L}{R} $.

Un packet switch tiene multiples links que lo conectan, cada link tiene un output buffer\queue que guarda los paquetes que el router esta planeando enviar por ese link. Si un paquete quiere viajar por ese link pero el link esta ocupado por otro paquete, este debe esperar en ese buffer. Como consecuencia, los paquetes al viajar sufren queueing delays los cuales dependen del estado de congestión de la red. Si llega un paquete y el buffer está lleno, el router va a deshacerse de un paquete del buffer o descartar el entrante, i.e packet loss.

Cuando al router le llega un paquete, como sabe a quien mandárselo? Existe distintas formas de implementar packet forwarding. Forwarding tables se utilizan para realizar el forwarding, cuando llega un paquete como header se tiene la dirección de destino, dicha dirección se parsea y se mira en una tabla a que nodo enviarla y elegir el outbound link apropiado. Y como se construye dicha tabla? Para ello se utilizan routing protocols los cuales setean automáticamente dichas tablas.

Circuit switching

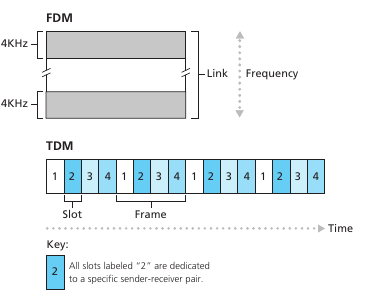

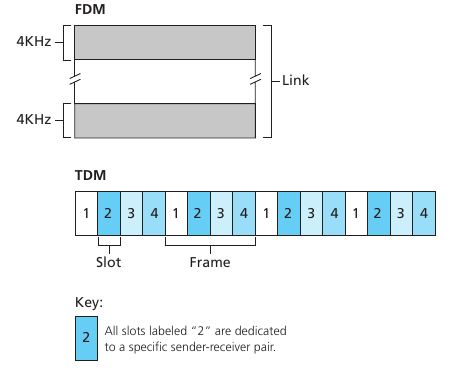

Circuit switching es otra alternativa para enviar datos por una red. En esta, los recursos que construyen el path son reservados por la duración de la comunicación entre dos sistemas finales. Como consecuencia, tienen que esperar para acceder a un communication link. Las redes telefónicas son el ejemplo estrella de circuit switching networks. Una diferencia clave es que cuando reservamos el recurso tenemos una tasa de transmisión asegurada, en cambio en la conmutación de paquetes, no hay ninguna garantía de que un paquete no se retrase en algún conmutador. un circuito en una red de conmutación de circuitos se implementa utilizando frequency division multiplexing (FDM) o time-division multiplexing (TDM). En FDM, las frecuencias del link se particionan y se asignan a los pedidos de conexión en un link. El rango de frecuencias asignada a un link se le llama ancho de banda (bandwidth). En TDM, el tiempo se divide en frames y a cada frame se divide en slots donde se asignan los pedidos de conexión.

Una de las críticas al modelo de circuitos es que sufre de silent periods esto es, momentos donde hay reservado un circuito pero en realidad no se está utilizando. Otro problema es que asignar un circuito es un problema complejo y requiere un tiempo considerable. Sin embargo, una vez que tenemos el circuito establecido es importante destacar que el tiempo de transmisión es independiente del número de links del circuito. A su vez, como cada usuario tiene que tener asignado una porción del link, la capacidad de usuarios que pueden usar la red de forma concurrente va a ser considerablemente menor.

Red de redes

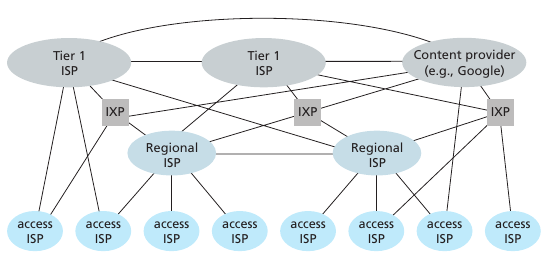

Los usuarios se conectan a un ISP para acceder a internet. A su vez, los ISP se deben conectar entre ellos para poder interconectar a todos los usuarios. La estructura de la red tiene carácter socio-económico. Los ISP se estructuran por regiones y con el objetivo de minimizar costos. Básicamente tenemos las ISP de acceso (tier-3) que son pequeñas, estás ISP se conectan a ISP's regionales o directamente con una tier-1. Las ISP's regionales se conectan con una ISP tier1 para acceder a los hosts de las demas regiones. A su vez las isps tier 1 se conectan entre si para brindar una cobertura de todo el globo. Las ISP chicas se conectan a las ISP grandes a través de PoP (Points of presence) lo cual es simplemente un lugar con muchos routers juntos. Multi-home se le llama cuando una ISP tiene más de 1 ISP proveedor. Peering se le llama al hecho de conectar dos ISPs geográficamente cercanas para reducir el costo de pasar por un ISP grande. Los internet exchange points (IXP) es un edificio independiente que se dedica a conectar multiples ISP en un punto neutral. Finalmente tenemos las content-provider networks las cuales son redes independientes a la internet administradas por grandes compañías privadas (e.g Google) para conectar sus servidores con sus servicios. Estas redes de contenido se conectan muchas veces de forma directa con las ISPs pequeñas para abaratar costos y tener un mejor control del servicio.

Delay, Loss, and Throughput in Packet-Switched Networks

Throughput is the amount of data per second that can be transferred. The internet has physical hardware and an increasing level of complexity, so many kinds of delays and throughputs appear.

Delay

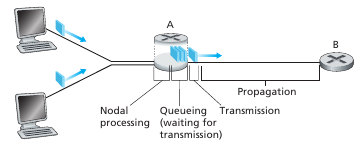

Existen muchos tipos de delays, los mas importantes en una circuito de conmutación de paquetes son:

- Nodal processing delay

- Queueing delay

- Transmission delay

- Propagation delay

- Nodal delay

Donde: $d{Nodal} = d{processing}+d{queueing}+d{transmission}+d_{propagation}$

La suma de los cuatro primeros generan el nodal delay, el cual es el delay que sucede en cada nodo de un path.

El processing delay es el tiempo requerido para examinar el header de un paquete y determinar a donde dirigirlo. También puede incluir otros factores, como el tiempo para hacer la corrección de errores del paquete recibido. Suele ser del orden de microsegundos. El queueing delay es el tiempo que espera el paquete en la cola esperando a ser transmitido por el comm link. Este tiempo depende de su posición en la cola al llegar y el estado de congestión de la red. Suele ser del orden de microsegundos a milisegundos. El transmission delay es el tiempo que me lleva meter el paquete en el link. Dado un paquete de L bits, y un link con una tasa de transmisión de R bits por segundo. el transmission delay es $ \frac{L}{R} $. Suelen ser del orden de microsegundos a milisegundos. El propagation delay es el tiempo físico que le lleva un bit propagarse a través del medio desde el origen al destino. El tiempo de propagación depende de la velocidad de propagación del medio y el largo del mismo. Es decir, dado un medio con velocidad de propagación $s$ metros por segundo y un link de largo $m$ metros el propagation delay es $ \frac{d}{s}$ sec. Suele ser del orden de milisegundos.

Cual delays es el predominante depende mucho del contexto. LAN, WAN, conexión satelital o dial up... Red vacía o llena de usuarios, todas estas variables y muchas mas afectan el retraso en cada nodo de la internet.

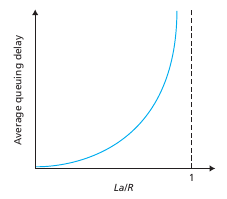

Queueing delay

El queueing delay es uno de los mas interesantes. Una de las variables para medirlo es el ratio $a\times \frac{L}{R}$ aka traffic intensity. Donde $L$ es el largo del paquete, $R$ es la tasa de transmisión y $a$ la tasa promedio en que llegan paquetes al conmutador. Si la intensidad de trafico está cerca de uno la cola va a tender a llenarse y tendremos packet loss! Por lo que es importante que la intensidad de la cola sea menor a 1+eps. Matemáticamente baste que la intensidad sea menor a 1, pero en la realidad es necesario que sea menos debido a la naturaleza del uso de la red los paquetes nunca llegan a tiempo constante sino que llegan en bursts aleatorios. Por lo que se necesita una intensidad menor a 1 para poder procesar estos bursts. La performance de un nodo no solo se mide en términos de su delay sino también de la probabilidad de que tenga un packet loss.

End-to-End delay

De forma general, para un paquete que viaja por N-1 routers, tenemos que el delay de un bit entre llegar de un host a otro es: $ d{end-end} = N\times (d{proc}+d{trans}+d{prop}) $. Asumiendo que las colas siempre están vaciás. Notar que esto es para redes homogéneas donde todos los nodos tienen los mismos tiempos de delay.

Extra delays

Existen otros tipos de delays asociados a los protocolos de comunicación y aplicaciones que generan delays adicionales. Un ejemplo es el packetization delay asociado a codificar el audio digital en Voice over IP VoiP applications.

Throughput

Considere que desea enviar un largo archivo entre un host A y B. El throughput instantáneo (ancho de banda), en un instante del tiempo, es la tasa en bits sobre segundo que el host B recibe un archivo. Si tengo $F$ bits, y la transferencia lleva $T$ segundos, el average throughput va a ser $\frac{F}{T} bits/sec$. En un path que pasa por muchos links el ancho de banda va a estar dado por el bottleneck link, esto es el link con menor ancho de banda. Notar que un link puede estar siendo usado por muchos usuarios por lo que el throughput instantáneo de un link es variable. Notar que el throughput es importante para descargar archivos grandes (de muchos paquetes), por ejemplo un video. Mientras que el delay toma una mayor importancia cuando queremos que un paquete llegue lo antes posible a un host (ej: online gaming o una videollamada)

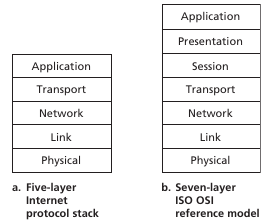

Protocol Layers and their service models

La internet sigue una arquitectura de capas, donde los diseñadores de la red organizaron los protocolos (+ el hardware y software que lo implementa) en layers. Cada protocolo de la internet pertenece a un layer. Cada uno de estos layer provee servicios realizando acciones dentro del mismo layer o utilizando layers inferiores. Un protocolo puede implementarse en una combinación de hardware y software. Protocol layering tiene ventajas conceptuales y estructurales y permite actualizar los sistemas con mayor facilidad. Sin embargo tiene sus contras como el overhead. La internet rompe muchas veces las estructuras obteniendo información de distintos layers en layers de más arriba o abajo. Todos los layers juntos se les llama el protocol stack, la internet tiene un stack de 5 capas.

Application layer

En esta capa es donde reside las aplicaciones de la red y sus protocolos. Estos incluyen: HTTP (transferir documentos), SMTP (email), FTP (archivos), DNS (website.com -> ip address domain name service), etc. Un protocolo de application es distribuidor entre muchos hosts, donde una aplicación desde un host usa el protocolo para intercambiar paquetes con otros. Estos paquetes desde el application layer se les llama mensajes (messages).

Transport Layer

El transport layer transporta los mensajes del application layer entre dos application endpoints. Existen dos protocolos en la internet: Transmission Control Protocol TCP y User Datagram Protocol UDP. TCP provee una conexión con delivery asegurado,flow control (matcher velocidades entre el sender/receiver) y congestion control. UDP no provee ninguno de los servicios mencionados anteriormente. Un paquete desde la capa de transporte se le llama segmento (segment)

Network layer

El network layer es responsable de mover network-layer packets: datagrams desde un host a otro. Básicamente el transport layer le manda un segmento y una destination address al network layer, y este se encarga de transportarlo al host destino. Este layer incluye el protocolo IP, que define el contenido de los datagrams. También contiene los protocolos de enrutamiento sobre que dirección toma un paquete al llegar a un router. A todos estos protocolos se les llama informalmente ip layer.

Link layer

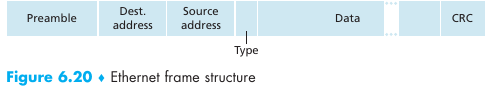

Para mover un paquete de un nodo a otro el network layer usa los servicios del link layer. En cada nodo el network layer le pasa el datagrama al link layer el cual manda el mismo al siguiente nodo, luego el link layer devuelve el datagrama al network layer en el siguiente nodo. Ejemplos de protocolos son Ethernet, wifi, DOCSIS (data over cable service interface specification), etc. Los paquetes de un link layer son llamados frames.

Physical layer

Mientras que el link layer mueve frames de un host adyacente a otro, el link layer se encarga de mover cada bit individual dentro del frame. Estos dependen de las características físicas del medio. Cada medio tendrá su physical layer protocol el cual considera las características del mismo (twisted pair copper wire, fiber optics, etc.)

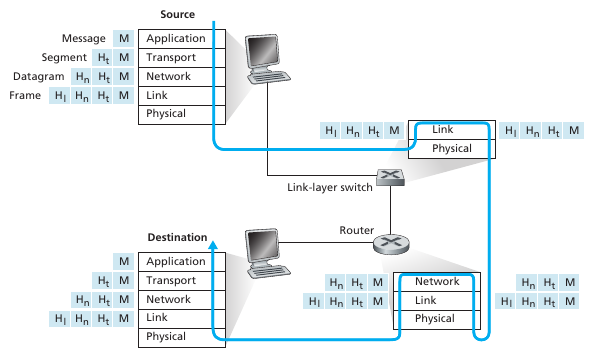

Encapsulamiento

El internet stack genera que los paquetes se envíen de la siguiente forma:

En esta imagen sale a la luz una diferencia importante entre un router y un link-layer switch: Un router implementa las capas 1-3 del protocolo mientras que un link-layer switch solo la 1-2. Es decir, el switch mira la ethernet address para saber por que link reenviarlo, pero necesita un router para poder enviar el paquete a la red y enrutarlo según la ip.

Esta forma de transporte genera la encapsulación de cada paquete de las capas, cada capa inferior encapsula el paquete de la capa superior y le agrega su información pertinente para cumplir el protocolo. Por ello, dado un layer tenemos que un paquete tiene 2 campos, el header que tiene la info que precisa el layer para implementar el protocolo y el payload con el contenido del mensaje a enviar.

El modelo OSI

Open systems interconnection es un modelo inventado por la ISO que se construyo de forma artificial allá por 1970. Agrega dos layer adicionales: Presentation layer y session layer. El primero permite a las aplicaciones interpretar el significado de los datos que intercambian. Esto incluye: Compresión de datos e encryption, descripción de los datos, etc. El session layer provee formas para delimitar y sincronizar el intercambio de datos, incluyendo formas de tener checkpoints y esquemas de recuperación. Son servicios bastante abstractos que caen dentro del application layer.

Network attacks

La internet fue pensada como un modelo hippie donde todos estamos conectados y nos confiamos entre si. Estó generó un monton de problemas cuando la internet se comenzó a utilizar de forma masiva. Distintos tipos de vulnerabilidades son:

Malware: A través de una conexión por internet un host le puede mandar un programa malicioso a otro. Un malware puede hacer cualquier cosa sobre el host dependiendo del acceso que tenga al sistema. Se le llama botnet a la red de computadoras infectada por malware que permite al atacante controlarla remotamente. Muchos tipos de malware son de tipo self-replicating, esto es que cuando infectan a un host tratan de replicarse en otros hosts que el host está conectado así expandiéndose. Se le llama virus al malware que requiere interacción de usuario para activarse y worms al que no requiere interacción explicita del usuario, pueden entrar por una vulnerabilidad directa del protocolo.

Server attacks: Otros problemas son los denial of service (DOS) attacks. Estos son ataques que tratan de exhaust los recursos de un servidor haciendo que el mismo no pueda continuar su funcionamiento normal. Existen 3 subtipos:

- Vulnerability attack: Consiste en enviar ciertos paquetes crafteados especialmente para un host con el objetivo de romperlo.

- Bandwidth flooding: El atacante enviá tantos paquetes que el access link del servidor se congestiona, no permitiendo a los usuarios reales llegar al servidor

Connection flooding: El attacker establece muchas conexiones TCP "semi abiertas\abiertas" y no las cierra. La performance del host se reduce por la cantidad de conexiones que tiene abierta no permitiendo a los usuarios reales establecer una connexion legitima.

Los ataques que se realizan desde una botnet se les llaman distributes DoS (DDoS).

SNIFF: Es posible capturar los paquetes que se transmitiendo a través de los enlaces. Un recibidor pasivo que captura cada paquete que pasa por la red se le llama packet sniffer. Un sniffer puede colocarse tanto en LANs como en Wifis. Defensas al sniffing se basan en el encriptado de mensajes.

SPOOF: Un host puede pasarse por alguien que no es o decir que es algo que no es alternado los headers que envía. La capacidad de inyectar paquetes en la internet con un dirección fuente falsa se le llama ip spoofing. La solución a esto es implementar end-point authentication. La cual verifica que ambos lados de la conexión verifican quien dicen ser.

Parte II - Application Layer

Principles of network applications

Network application development is writing programs that run on different end systems and communicate with each other over the network. Notar que el software que se diseña es para los sistemas finales, los sistemas intermedios que constituyen la red no implementan el application layer. Notar que no es lo mismo la arquitectura de la aplicación que la arquitectura de la red, la red implementa una arquitectura en capas, una aplicación es diseñada por los creadores para su conveniencia y dicta como se comporta los sistemas finales. La arquitectura de la red solamente provee un set especifico de servicios a estas apps. Las dos arquitecturas de aplicaciones predominantes son las de cliente/servidor y P2P (peer-to-peer). En la arquitectura cliente-servidor hay un host que recibe pedidos de muchos otros hosts (clientes). Un ejemplo clásico de esto son las aplicaciones web,ftp,telnet y email. Por lo general el servidor tiene una IP bien conocida y siempre esta disponible, permitiendo al cliente contactar al mismo en cualquier momento. Los data centers son lugares donde se alojan los hosts para asegurar su disponibilidad y poder atender a muchos clientes. En una arquitectura P2P cada host es a la vez un cliente y un servidor. Una de las ventajas de esto es su self-scalability y reducción de costos. Las desventajas de las P2P son problemas de seguridad, performance y reliability por su estructura descentralizada.

Processes Communicating

Dos procesos (SO) que se encuentran en distintos hosts se comunican intercambiando mensajes a través de la red. Una network application consiste en un par de procesos que se envían mensajes a través de una red. Por ejemplo como un Web server intercambia mensajes con el navegador de un cliente. En todo par de procesos comunicándose siempre hay una relación cliente servidor:

In the context of a communication session between a pair of processes, the process that initiates the communication (that is, initially contacts the other process at the beginning of the session) is labelled as the client. The process that waits to be contacted to begin the session is the server.

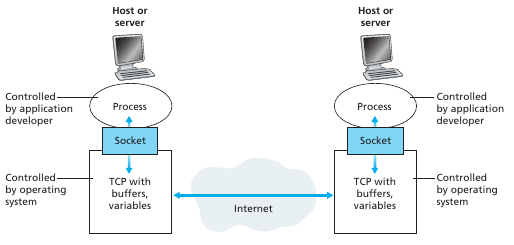

The Interface Between the Process and the Computer Network

Ahora bien, como hace un proceso para envíar un mensaje por la red? Un proceso envía y recibe mensajes a través de una interfaz de software llamada socket. Un socket es como una puerta, si los procesos están dentro de una casa, para enviar un mensaje un proceso saca un mensaje por una puerta, el mensaje recorre la red, y termina en la puerta de la casa de otro proceso para que este lo levante. Un socket es la interfaz entre el application layer y el transport layer en un host. También se le llama application programming interface (API) entre la aplicación y la red. El desarrollador tiene control de todo lo que sucede en el socket desde el lado de la aplicación pero casi ninguno del lado de la capa de transporte. Las opciones que tiene en la capa de transporte son elegir el protocolo de transporte (TCP y UDP) y elegir un par de parámetros de la capa de transporte como el tamaño máximo y mínimo de buffers y segmentos. Cuando se elige un protocolo la aplicación usa los servicios de trasporte provisto por ese protocolo.

Adressing process

Como hace un proceso para referirse a un proceso en otro host en particular? Para ello se necesitan direcciones. Para identificar a un proceso se necesitan dos cosas: La dirección del host y un identificador para el proceso que se encuentra en dicho host. En la internet el host se identifica con una ip address, lo cual es una tira de 32 bits que identifica a un host de forma única. Para identificar a un proceso (o mejor dicho, al socket donde enviar el mensaje) se necesita saber el port number, ya que un host tiene muchos sockets funcionando. Puertos estándar son el puerto 80 para servicios web, el mail (SMTP) por el puerto 25, y muchos más.

Servicios de transporte disponibles para aplicaciones

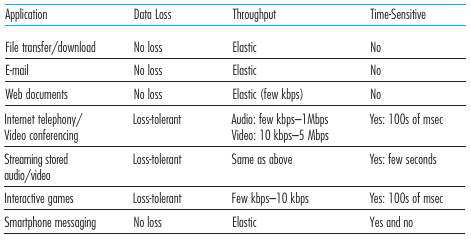

La aplicación se encarga de mandar mensajes por un socket a un socket destino en otro host, el transport layer tiene la responsabilidad de hacer llegar esos mensajes al socket del proceso que quiere recibir el mensaje. La internet provee más de un protocolo de transporte, los cuales están caracterizados por los servicios que ofrecen:

Reliable data transfer: Muchas aplicaciones necesitan la garantía de que cuando envíamos un mensaje este llegue de forma integra al destino, no pueden haber errores. Pero cuando la cola de un router se llena y hay un packet loss que hacemos? Se necesita hacer algo para asegurar que los datos enviados por una app llegan de forma completa e integra al otro lado. Los protocolos que ofrecen esta garantía se dicen que ofrecen reliable data transfer. Si el protocolo de transporte provee este servicio, el proceso puede mandar datos al socket y tener la garantía de que los datos van a llegar sin errores al otro proceso. Si no se provee este servicio, puede pasar que algunos paquetes nunca lleguen al proceso destino, esto puede ser acceptable en aplicaciones loss tolerant como servicios de streaming de audio/video.

Throughput: Un protocolo podría asegurar un throughput al utilizarlo. Aplicaciones que tienen requerimientos de throughput se les llaman bandwidth-sensitive applications, un ejemplo de esto son los servicios de streaming. Muchas de estas aplicaciones utilizan técnicas de codificación y regulación para poder matchear el contenido que envían con el throughput de la red. Las elastic applications utilizan todo el throughput que tienen disponible, ejemplo de esto es el correo o de descarga de archivos.

Timing: Un protocolo podría asegurar que le va llevar no mas de x segundos enviar un mensaje a un host. Esto seria particularmente util n sistemas de tiempo real o aplicaciones de llamada telefonica.

Security: El protocolo de transporte podría proveer servicios de seguridad, por ejemplo encriptando todos los datos que la aplicación coloca en el socket para su envío seguro.

La siguiente lista muestra las necesidades de algunas aplicaciones:

TCP

El modelo de servicio TCP incluye un servicio orientado a conexiones y de reliable data transfer. Cuando una app usa este protocolo recibe ambos de estos servicios. Connection oriented service refiere a que el cliente y servidor intercambian información antes de que los mensajes a nivel de aplicación comienzan a ser enviados/recibidos. Este handshaking alerta al cliente y servidor para prepararse para la transferencia de paquetes. Tras realizado el handshake, se dice que existe una conexión TCP entre los dos sockets. La conexión se dice que es full-duplex ya que ambos pueden enviar mensajes entre si al mismo tiempo. Cuando la aplicación termina de enviar mensajes debe "desarmar" la conexión TCP. A su vez, los procesos que se comunican pueden confiar en TCP para enviar cada uno de los bits que envían y que llegan en el orden correcto. TCP también incluye un control de congestión, que hace un throttle sobre los paquetes que envía cuando la red está congestionada. En sí TCP (ni UDP) proveen encriptación. Se ha desarrollado una mejora a TCP llamada Secure Sockets Layer el cual extiende TCP y provee servicios de seguridad como encriptación y authentication. SSL no es un protocolo de transporte sino una mejora de TCP que está implementada en el application layer. SSL tiene su propia Socket API que los programadores deben utilizar si quieren utilizar sus servicios.

Clase: TCP ofrece un stream, UDP ofrece un mensaje. TCP asegura que no se pierden bytes en un stream. Si mi aplicación tiene el concepto de mensaje, tengo que delimitarlo de alguna manera. Ejemplo practico: Vos en TCP enviás 'a' y luego 'b', el proceso servidor recibe 'ab', recibe todo el stream!!!

UDP

UDP es un protocolo liviano que provee servicios mínimo, es connectionless por lo que no hay handshake. Provee unreliable data transfer, no asegura que el mensaje llegue ni que llegue en el orden correcto. No tiene control de congestion.

Nótese que la internet no provee ningún servicio de timing y throughput, trata de hacer lo mejor posible y la mayor parte de las veces lo cumple. Es posible que esta filosofía de poco compromiso es lo que le dio a la Internet la versatilidad para crecer a un ritmo tan acelerado y convertirse en la red de computadoras que es hoy en dia.

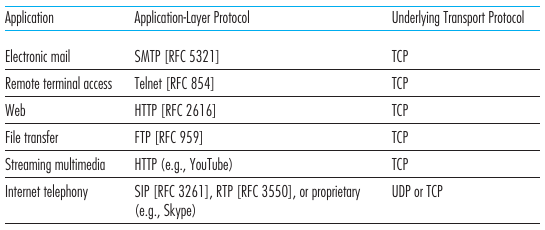

La siguiente imagen muestra populares protocolos del application layer y el transport layer que se encuentra por detrás:

Application-Layer Protocols

Como se estructuran los mensajes que se envían al socket? Un protocolo de la capa de aplicación define como un proceso de una aplicación, corriendo en distintos hosts, se pasa mensajes entre sí. En particular define:

- El tipo de mensajes intercambiados. Ej: mensajes request y response

- La sintaxis de los mensajes, los campos de los mensajes y como se delimitan

- La semántica de los campos, el significado de la información que se encuentra en dichos campos

- Reglas para determinar cuando y como un proceso enviá y responde mensajes.

Los siguientes temas tratan en particular de los principales protocolos de aplicación de internet. Es importante antes notar la diferencia entre una network application y un application-layer protocol. El ultimo es solo una parte de una aplicación en red. Por ejemplo, La Web es una aplicación servidor/cliente que permite a los clientes obtener documentos. La aplicación web consiste de muchos componentes: Un standard para el formato de documentos (html), un browser (chromium), web servers (apache) y un application layer protocol: HTTP.

The Web & HTTP

Overview of HTTP

HyperText Transfer Protocol es uno de los protocolos de aplicación más importantes de la web. HTTP se implementa en dos programas: un programa cliente y un programa servidor. El cliente y el servidor hablan entre sí intercambiando mensajes HTTP.

Repasando antes algunos conceptos de la web: Una webpage consiste en objectos. Un un objeto es un archivo. Ej: HTML,JPEG,Java applet. Estos son referenciables con un URL. La mayoría de los sitios web tienen un base html site donde se referencia a los objetos. Web browsers implementan el lado cliente del HTTP (Ej: firefox) y Web servers implementan el lado servidor del HTTP, hosteando objetos que son accesible con una URL. Ej de webservers son: Apache, Microsoft Internet Information Server.

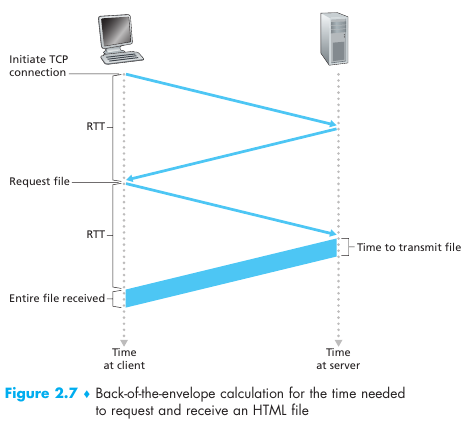

HTTP usa TCP como su protocolo de transporte. Primero, el cliente HTTP inicia una conexión TCP con el servidor, una vez establecida el cliente y el servidor acceden a TCP por sus interfaces de socket. El cliente envía una HTTP request al socket del servidor y recibe un mensaje de respuesta HTTP en su socket. Una vez que se envía el mensaje TCP se encarga de mandarlo. I love arquitectura en capas :). Notar que el servidor envía archivos sin guardar información sobre el cliente. Por ello se dice que HTTP es un stateless protocol.

Persistence of connections

En las aplicaciones de internet el cliente se comunica por un periodo de tiempo largo y hace varias requests al servidor. La cuestión está en si hay que iniciar una conexión TCP cada vez que hacemos una solicitud o podemos dejar esta conexión abierta y enviar todas las requests dentro de esta conexión. Estos dos approaches son llamados persistent and non-persistent connections. HTTP por defecto usa conexiones persistentes, pero es posible configurarlo para usar el modo no peristente.

Si accedemos a una pagina html con 10 imágenes tenemos que hacer 11 conexiones TCP. Estas conexiones pueden realizarse en paralelo dependiendo del navegador. Se define el round-trip time (RTT) como el tiempo que le lleva a un paquete epsilón viajar del cliente al servidor y luego volver al cliente. RTT incluye delays de propagación procesamiento y encolamiento. Cuando clickeamos un hyperlink sucede un "three-way handshake": básicamente el cliente manda un pequeño segmento TCP al servidor, el servidor lo acepta y responde con otro segmento TCP y finalmente el cliente acepta y vuelve a enviar al servidor. Al completar las dos partes del handshake (1 RTT) el cliente envía un HTTP request file junto con el acknowledge del "three-way handshake a la conexión TCP". Al llegar la request al servidor este le envía el archivo finalmente. Por lo tanto el tiempo total de respuesta para envíar un archivo es siempre 2 RTT más el tiempo de tansmision del archivo desde el servidor.

Por cada objeto que pedimos "TCP buffers must be allocated and TCP variables must be kept in both server and client". Esto es una carga para el servidor web, que atiende miles de clientes. Y agrega un RTT adicional. En una conexión persistente se deja abierta la conexión tcp y se puede enviar un sitio web con muchos objetos en una sola conexión, a su vez las requests se pueden hacer de forma consecutiva sin esperar respuestas generando como un pipeline. Por lo general el servidor HTTP cierra la conexión cuando se deja de usar por un cierto tiempo (configurable timeout). HTTP/2 Es el protocolo que implementa pipelining con requests y respuestas enviadas de forma multiplexada en una misma conexión y un mecanismo de prioritization de requests.

HTTP Message format

HTTP Request message

Un mensaje de HTTP típico enviado por un cliente tiene la forma:

GET /index.html HTTP/1.1

Host: www.dogs.com

Connection: close

User-agent: Mozilla/5.0

Accept-language: en

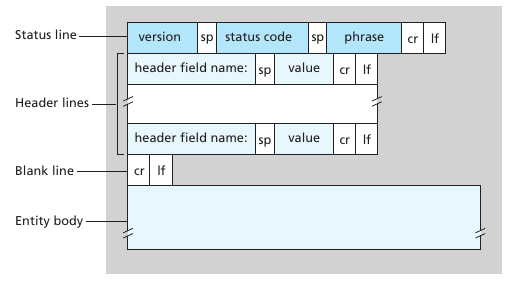

Un request message puede tener una cantidad variable de lineas. La primera linea se le llama request line y las siguientes header lines. La request line tiene 3 campos: el método, URL y versión de HTTP. El método puede tomar los valores : {GET,POST,HEAD,PUT,DELETE,etc.}. La mayoría de las requests usan el método GET. El campo host indica en donde se encuentra el host, este campo es necesario para implementar los web proxy caches. Connection: close hace que el browser le diga al servidor que cierre la conexión cuando termine de enviar el objeto pedido. User agent habla de quien es el navegador, esto permite al servidor dar diferentes versiones del mismo objeto al igual que el accept language. Estos headers se le llaman negotiation headers. El formato de una HTTP request puede verse en la siguiente figura:

Notar que en el ejemplo de arriba el "entity body" está vació. Este se usa en el método POST para indicar los campos que el usuario llenó. Sirve por ejemplo para llenar formularios. Sin embargo enviar datos al servidor también puede hacerse con el método GET y incluir los datos ingresados dentro del url. Un ejemplo de esto es www.domain.com/video/search?search=cute+cats. El método head se utiliza para debuggear, ya que hace que el servidor responda enviando un mensaje HTTP pero sin el objeto solicitado. El método PUT sirve para subir objetos a un path especifico de un web server. El método put sirve para subir archivos a un servidor. El método DELETE sirve para borrar objetos de un servidor.

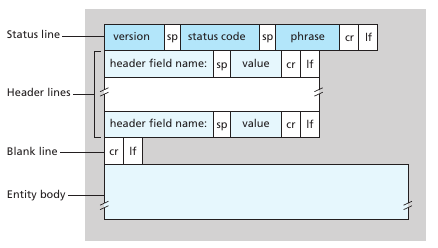

HTTP Response message

La respuesta a la HTTP request enviada anteriormente podría ser:

HTTP/1.1 200 OK

Connection: close

Date: Tue, 18 aug 1450 12:12:12 GMT

Server: Nginx/2.1 (NixOS)

Last-Modified: Tue, 18 Aug 2027 14:11:11 GMT

Content-length: 9999

Content-type: video/mkv

(DATA DATA DATA)

Un HTTP response se compone de tres secciones: status line, header lines and entity body La primera tiene 3 campos, la version del protocolo HTTP, un código de status y un mensaje de status. Las header lines, connection close indica que el servidor va a cerrar la conexión tras enviar el mensaje. La fecha es el momento en que el servidor envió el mensaje. El campo server indica el tipo de servidor que envió el mensaje, las modified indica la ultima vez que se modificó el archivo, esto es importante para el caching. El largo del contenido y el tipo de contenido describen el contenido del entity body.

Ejemplos clásicos de response status son: 200 OK (todo cool), 301 Moved Permanently (Indica que el objeto se movió a un nuevo path, se incluye en Location: el nuevo path, el navegador automáticamente solicita este nuevo URL) y 400 Bad request (error genérico del servidor indicando que no entendió la request), 404 Not Found (no existe el objeto pedido), 505 HTTP Version Not Supported (Al pedir HTTP/8.0)

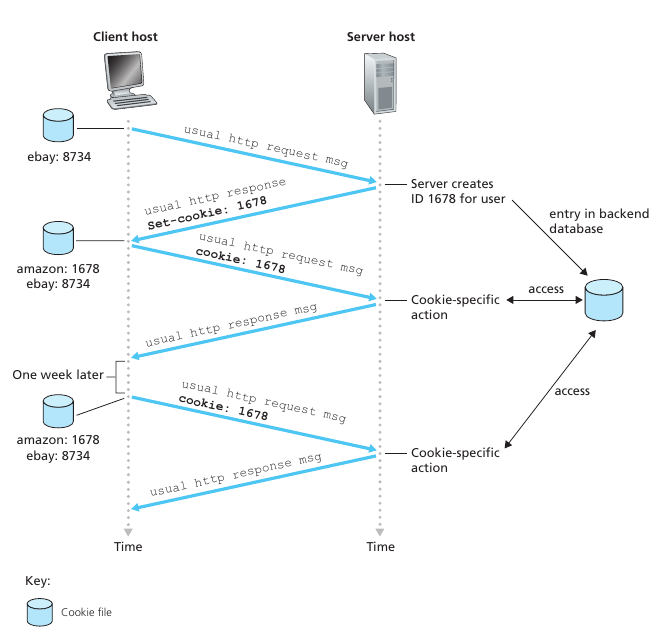

Cookies

Un servidor HTTP es stateless. Entonces como hacen las webs hoy en dia para identificar usuarios y crear los mecanismos de logins? Respuesta: cookies! La tecnología de las cookies tiene 4 componentes: un cookie header que se encuentra en el HTTP response message, un cookie header line en el HTTP request message, un archivo cookie guardado en el navegador del cliente, y una database en el servidor. Básicamente en el primer contacto el servidor responde con un header Set-cookie: x. El navegador se guarda este x y la próxima vez que haga un request al servidor le va a enviar en el header la linea Cookie: x. De esta forma el servidor puede identificar a un usuario.

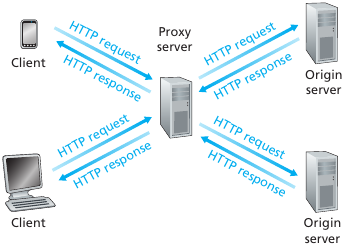

Web caching

Un web cache\proxy server es una entidad en la red que satisface HTTP request en nombre de un Web server origen. Un web cache tiene su propio storage y mantiene copias de objetos recientemente solicitados. Un navegador puede ser configurado para que todas sus HTTP requests sean primero dirigidas a un web cache. Básicamente el comportamiento del mismo es: Se envía el request al web cache, el web cache la recibe y se fija sí tiene el objeto. Si no lo tiene le envía un request al servidor origen, cuando el web cache recibe el archivo se lo manda al cliente. Es una herramienta muy util para descongestionar la red y suelen ser adquiridos e instalados por un ISP. Reducen el trafico de la internet en general y el trafico hacia el exterior de una red, lo que reduce notablemente los costos operativos. A su vez, las Content delivery networks (CDN) instalan multiples a lo largo del planeta para localizar y aumentar la efectividad el trafico.

Conditional GET

Como hace el cache para verificar que la copia de un objeto solicitado está actualizada? Este mecanismo se le llama conditional GET. Una request conditional GET utiliza el método GET y incluye la linea en el header: If-Modified-Since: date. El conditional get se utiliza para que el cache le pregunte al servidor si un objeto fue modificado. Dado un objeto cacheado en una fecha d. El cache le envía una request al servidor origen que dice: GET (...) If modified since: d. Luego el servidor le responde con el archivo. Pero si este no fue modificado le va a llegar un header sin contenido, que dice solamente HTTP/1.1 304 Not Modified. Nos ahorramos un montón de trafico!

El correo

El mail service electrónico es uno de las aplicaciones más antiguas de la red. Tiene 3 componentes principales: user agents, mail servers y el Simple Mail Transfer Protocol (SMTP). Los user agents nos dejas leer,responder,etc. mensajes (Ej: Microsoft Outlook, Apple Mail). Mail servers son el core de la infraestructura, cada recipiente tiene su mailbox ubicada allí. Un mailbox administra los mensajes de cada usuario. Ej: Bob escribe un msg en su user agent, lo envía a su mailbox en el servidor, y viaja al mailbox del servidor de destino. Si no se pude enviar el mensaje, los mensajes quedan en una message queue que cada cierto tiempo trata de reintentar. Si no lo logar tras muchos intentos le avisa al usuario que no se pudo.

SMTP es el protocolo para la aplicación de correo electrónico. Utiliza tcp para la transferencia de mensajes. SMTP tiene dos lados: El cliente que es el que ejecuta en el servidor que manda el mensaje y el servidor que es el servidor que tiene el mailbox destino. Un mail server es tanto un cliente y un servidor dependiendo de lo que este haciendo.

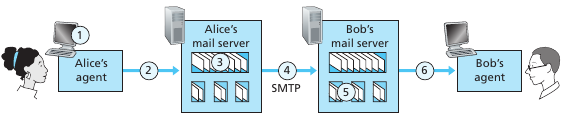

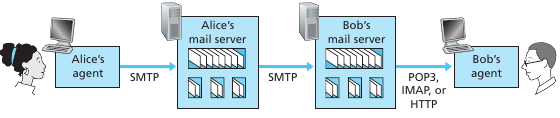

SMTP

Es un protocolo muy viejo. Requiere que el contenido de los mensajes sean de 7-bit ASCII. Hay que codificar si quiero mandar fotos por ej... Lo mensajes básicos de SMTP son: A invoca su user-agent y compone un correo. El user agent de A envía el mensaje al servidor, que lo encola. El servidor (cliente SMTP) manda el mensaje al servidor destino. Tras el handshaking, SMTP manda el mensaje al servidor. El servidor de B recibe el mensaje y lo coloca en el mailbox. B invoca su agente para leer el mensaje.

Una diferencia notable con HTTP es que este es un pull protocol, i.e alguien cargar información en un servidor y los usuarios pullean la información a su conveniencia. SMTP es un push protocol, el sending mail pushea un archivo al mail server destino. La conexión TCP es iniciada por la maquina que quiere envíar el archivo. Notar que HTTP se pide de a un objeto. En SMTP podrías poner todos los objetos (fotos por ej) en un solo mensaje.

Ejemplo comunicación de SMTP

S= servidor, C= cliente. Antes se hace un handshaking. La conexión TCP es persistente, se podría envíar mas mensajes. (MAILFROM...) se tiene que cerrar la conexión con el QUIT del cliente.

S: hamburger.edu

C: HELO crepes.fr

S: 250 Hello crepes.fr, pleased to meet you

C: MAIL FROM: <alice@crepes.fr>

S: 250 alice@crepes.fr ... Sender ok

C: RCPT TO: <bob@hamburguer.edu>

S: 250 bob@hamburguer.edu ... Recipient ok

C: DATA

S: 354 Enter Mail, end with "." on a line by itself

C: Do you like MEAT?

C: How about Sausages?

C: .

S: 250 Message accepted for delivery

C: QUIT

S: 221 hamburger.edu closing connection

Formato SMTP

Al envíar el mensaje antes se incluye un header. El header está separado por una linea CRLF. El header tiene que tener necesariamente los siguientes valores (mismo formato http): From: y To: Para indicar de quien y a donde es el mensaje. Ej de header:

From: guille@mailbox.acc.com

To: annie@lol.com

Subject: Poggers

Acceso al mail server

Observar que en la mayoria de los casos el user agent de los usuarios reside en los dispositivos de los mismos y el mail server es un servidor contratado y mantenido por una compañía. También observar que "A" desde su user agent le enviá por SMTP el correo a su mailbox, y luego el servidor usa SMTP para enviar el correo al servidor destino. El user agent no habla directo con el servidor destino porque si el mensaje falla en envíar no podría encolarse ya que el user agent no tiene por que estar siempre online.

Ahora bien, como accede B a sus correos desde el user agent? Como SMTP es un push protocol no puede utilizarlo para recibir datos. Debe usar otros: Post Office Protocol V3 POP3, Internet Mail Access Protocol IMAP or HTTP.

POP3

POP3 es un protocolo simple y legible. Su simpleza la da funcionalidad limitada. Al establecer la conexión TCP, POP3 tiene 3 etapas:

- autorización: El user agent manda un username y un password (no encriptado) para autenticar

- transacción: El user agent recibe mensajes, puede marcar mensajes para borrar, obtener estadisticas para el mail o deshacer los mensajes marcados para borrar

- update: Ocurre tras invocar "quit", cierra la sesión POP3 y el servidor borra los mensajes seleccionados.

El servidor siempre responde "+OK\ -ERR" dependiendo de lo que envía el usuario. Ejemplo de login en POP3: telnet mailsrv 110 +OK POP3 server ready user bob +OK pass hungry +OK user successfully logged on

La transacción puede ser download and delete o download and keep. En la primera al pedir un mensaje luego se borra, en la anterior el agente de usuario deja el mensaje en el mail server tras descargarlo (recordar que el user agent es un programa)

C: list

S: 1 498

S: 2 912

S: .

C: retr 1

S: (texto)

S: (texto)

S: .

C: dele 1

C: retr 2

S: (texto)

S: .

C: dele 2

C: quit

S: +OK POP3 server signing off

IMAP

IMAP es un protocolo más complejo que permite a los usuarios crear/borrar y mover carpetas y en ellas mismas almacenar mensajes. Cuando un mensaje llega al servidor se guarda en la carpeta por defecto inbox. El recipiente luego la puede mover a donde quiera. Esta estructura de carpetas es remota y el usuario puede acceder desde cualquier user agent a sus carpetas. Una funcionalidad importante es que IMAP tiene la capacidad de recibir solo algunos componentes de un mensaje (ej el header) esto es relevante en conexiones lentas.

HTTP

Es la forma más usada hoy en dia, se accede al correo a través de un navegador web. El usuario se comunica con el mailbox via HTTP. Tanto para envíar como recibir mensajes se puede utilizar este protocolo. Sin embargo para la comunicación entre servidores de correo electrónico se sigue usando SMTP

DNS - The internet's directory service

Las maquinas se identifican por IP address ya que es size-fixed y numérico, pero los humanos nos gusta identificarlas por su memonico hostname. Es necesario entonces un mapping $I \leftrightarrow H$. Esta es la tarea del Domain Name System (DNS). El DNS es una base de datos distribuida implementada en una jerarquía de servidores DNS + un application-layer protocol que permite a los host hacer queries a la base de datos. El DNS usa el protocolo UDP en el puerto 53. Tiene la particularidad que es una aplicación que es utilizada por protocolos de otras aplicaciones (HTTP, SMTP) para resolver los hostnames. Un pedido con http con hostname sigue estos pasos:

- El usuario, que corre el lado cliente de la app DNS y tiene un navegador, extrae el hostname de la URL y se lo pasa al cliente DNS.

- El cliente DNS envía una query con el hostname al servidor DNS

- El DNS client recibe (idealmente) una respuesta, que incluye la IP del hostname

- Con la ip del hostname el navegador inicia una conexión TCP para el proceso HTTP en el puerto 80 de dicha IP.

Funcionalidades DNS

Host aliasing: Un host con un nombre complicado como "relay1.weswer23.google.com" puede tener muchos aliases como "google.com" o "goGle.com". El primer hostname se le llama canonical hostname. El DNS puede ser invocado para obtener el canonical hostname de un alias y su IP.

Mail Server Aliasing: Se utiliza para obtener lo que va después del @. Se utilizan aliases. Ademas el aliasing permite que el servidor web de una compañía tenga el mismo alias que el servidor mail de esta.

Load Distribution: Se puede asociar muchos ip address a un alias. Cuando un cliente hace una query del hostname el servidor DNS responde con todo el set de IPs pero va rotando el orden de la lista de ips, de esta forma se logra un balanceo natural entre los servidores (por lo general un cliente envía la HTTP request de el primer IP de la lista)

Overview

El servidor dns funciona como una caja negra para el cliente, el pide y recibe. Pero en realidad cuando al servidor le llega una request, al ser una base de datos distribuida hay un mecanismo de comunicación complejo. Por que no se optó por hacer un único servidor centralizado? Respuesta: Si se rompe nos quedamos sin internet, el trafico sería inmensurable, los que están lejos se joden, mantenimiento de algo gigante que debe actualizarse frecuentemente.

It simply doesn't scale.

Para encarar con el problema, DNS usa muchos servidores organizados en una estructura jerárquica. No hay ningún servidor que tenga todos los mappings de los hosts. El mapping se distribuye entre los servidores DNS. Existen 3 clases de servidores DNS:

- Root DNS Servers: Existen unos 400 alrededor del mundo, administrados por 13 organizaciones (Kurose,2016?). Estos proveen las IP de los servidores TLD

- Top-level domain (TLD) servers: Para cada top-level domain (ej: com, org, net, edu, moe, etc.) incluyendo los nacionales (uy ,us ,jp ,uk, etc) hay un servidor TLD (o un cluster).

- Authoritative DNS server: Cada organización con hosts públicos en la internet debe tener un registro DNS publico que hace el mapping del el nombre de sus hosts a un IP address. El authoritative DNS server de cada organización se encarga de ellos. Alternativamente, una organización puede pagarle a alguien para que sus hosts sean publicados en el servidor authoritative DNS de un tercero.

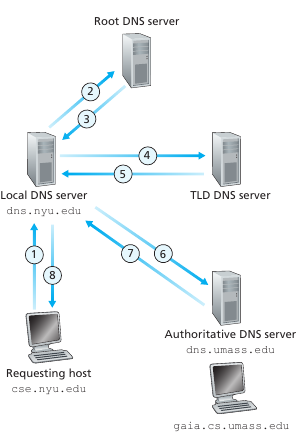

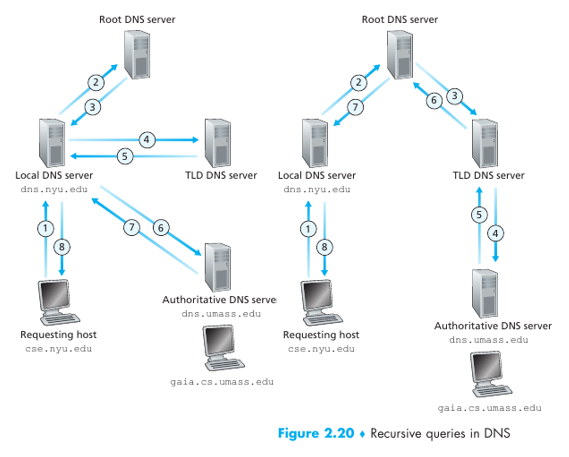

Cuando un cliente quiere la ip de nootnoot.org primero el cliente contacta uno de los servidores root, el cual retorna la ip address de un TLD server para el dominio ".org", luego el cliente contacta con ese servidor TLD el cual retorna el authoritative server de nootnoot.org, el cual al ser contactado por el cliente devuelve el address de 4chan.org

Existe un servidor DNS fuera de la jerarquía: el local DNS server. Cada ISP tiene un local DNS (aka default name server). Cuando un host se conecta a un ISP esta le provee las IP de sus servidores dns locales. No suelen estar muy lejos (en path) del host. Cuando un host hace una query, esta es envíada al servidor DNS local, la cual actúa como un proxy forwarding la query en la jerarquía de servidores. Ejemplo de query dns:

Se le llama recursive queries a aquellas que se mandan y luego el cli habla con otro o la procesa iterative queries a las que se hace una query, responde y luego se hace otra. Ejemplos (la segunda es toda recursiva):

DNS Catching

Se usa caching para evitar delay de performance, y reducir los mensajes en la red. Básicamente cuando un servidor recibe la ip de un host esta se la puede guardar, cuando viene otro por el mismo host le puede devolver la ip que había guardado! Yay! Los elementos se van descartando a medida que van pasando los dias, de esta forma toda la jerarquía de servidores dns puede ser evitada y solo utilizar el local dns para los hostname mas populares.

DNS records

Los DNS servers guardan en la base de datos resource records (RR), incluyendo RR's que tienen H<>IP mappings. Cada mensaje de respuesta DNS lleva 1 o más RRs. Un resource record es una cuaterna que contiene:

$(Name, Value, Type, TTL)$ TTL es el tiempo de vida del RR. Indica cuando debe ser borrado del cache. Type indica el tipo:

- Type = A: Indica que Name es el hostname y value es la IP del hostname. Es el preciado H<>IP

- Type = NS: Indica que Name es un dominio y value es el hostname del DNS autoritario que sabe como obtener dicha IP

- Type = CNAME: Indica que Value es el canonical hostname para el hostname alias Name. Ej (foo.com,relay1.foo.com,CNAME,18273)

- Type = MX: Indica que Value es el canonical name server que tiene como alias el hostname Name. (Servidores de correo que sirve para ese dominio (gmail.com, alt4.gmail-smtp-in-l.google.com)) El DNS authoritative de un hostname tiene un un type A RR de este. Otros pueden tenerlo en su cache.

DNS Messages

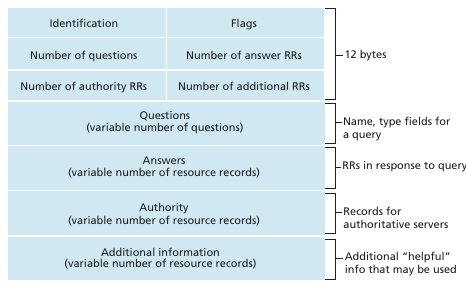

Tanto las query como las reply tienen el mismo formato de mensaje:

Los primeros 12 bytes son de la sección de header. Los primeros 16 bits identifican la query, permitiendo al cliente matchear la respuesta con la identificación. Una flag de 1 bit marca si el mensajes una respuesta (1) o una query (0). Una flag de 1 bit se settea cuando el que responde es el DNS authoritative. 1 bit flag indica si el que hace la query le gustaría que el host haga recursión. Luego hay 4 campos con números que indica la cantidad de secciones de cada tipo que hay

La sección question contiene información sobre la query que se esta haciendo. Contiene:

- Namefield: name that is being queried

- Type: type of question being asked about the name

Cuando es una respuesta del servidor DNS, la answer section contiene los RR del nombre que fue queried.

La authority section contiene los RR de otros servidores autoritarios

La additional section contiene otros RR útiles. Por ejemplo si es una MX query puede contener el canonical hostname del mail server y contiene un type A record con el ip del canonical hostname.

Insertar un registro a una DNS

Para ello tenes que pagarle a un registar. Cumplir todas las condiciones (no esta en uso el hostname.com etc). Para registrar un hostname se debe proveer los nombres e ips de tu dns authoritative primario y secundario. El registar se va a asegurar que un RR tipo NS y tipo A sean ingresados en el TLD .com server. Ponele que tu dns authoritative es dns.hostname.com con ip 123.123.123.1 entonces el registar ingresara al TLD DNS: (dns.hostname.com,123.123.123.1) y (hostname.com,dns.hostname.com, NS). Ahora existe un protocolo que permite actualizar los servidores dns, pero antes lo hacia alguien de forma manual.

P2P

Se puede probar matemáticamente la escalabilidad de las redes P2P frente a las server/client (ver Kurose). Es una arquitectura alternativa que se basa en que no siempre los hosts van a estar disponibles y en una aplicación en cada sistema se encuentran las partes cliente y servidor.

BitTorrent

BitTorrent es un protocolo p2p popular para distribuir... archivos. La colleccion de compas participando en la distribución de un archivo se le llama torrent. Peers en un torrent descargan chunks de un archivo y se los distribuyen entre ellos, tanto envíando como recibiendo. Un peer siempre puede salir del torrent, o puede volver.

Como me conecto con los peers? Cada torrent tiene un nodo cliente/servidor llamado tracker. Cuando un peer se une se registra en el tracker y le informa periódicamente que siguen el torrent. El tracker entonces tiene la lista de todos los peers del torrent en un momento dado.

Cuando un nuevo peer se uno el tracker le manda un subconjunto de peers. El nuevo peer trata de establecer una conexión TCP con todos los peers (concurrentemente). Los otros peers que aceptan la conexión se llaman neighbouring peers. Con el tiempo el subset de neighbouring peers va cambiando, estos son los que se mandan las chunks. Las chunks se piden según el criterio rarest first maximizando la integridad de un archivo. Dado un peer, a quien le manda chunks. Bit torrent sigue un algoritmo de negociación que en esencia se basa en que los top x que más datos me mandaron yo también les voy a mandar y a los otros los tengo ahi, si alguno me empieza a mandar y sube al top x entonces le voy a empezar a mandar a el. A los peer que se les manda chunks se llaman unchoked, los que están chocked y reciben chunks se les llama optimistically unchoked ya que podría subir.

Video Streaming

El video consume muchos recursos de la preciada internet. Para que todos los usuarios puedan acceder a ver el video, creamos muchas versiones del video a distintos bitrate. Los usuarios pueden decidir cual quieren en función de su ancho de banda disponible.

DASH

In HTTP streaming, the video is simply stored at an HTTP server as an ordinaryfile with a specific URL. When a user wants to see the video, the client establishes a TCP connection with the server and issues an HTTP GET request for that URL. The server then sends the video file, within an HTTP response message, as quickly as the underlying network protocols and traffic conditions will allow. On the client side, the bytes are collected in a client application buffer. Once the number of bytes in this buffer exceeds a predetermined threshold, the client application begins play- back—specifically, the streaming video application periodically grabs video frames from the client application buffer, decompresses the frames, and displays them on the user’s screen. Thus, the video streaming application is displaying video as it is receiving and buffering frames corresponding to latter parts of the video.

Esto tiene el problema de que todos los clientes reciben la misma version del video, a pesar de sus distintos throughputs. Por ello se desarrollo un nuevo tipo de HTTP: Dynamic Adaptative Streaming over HTTP (DASH). En DASH, el video es codificado en muchas versiones con distinto bitrae. El cliente pide dinamicamente los chunks (segmentos de video muy cortos). Cuando hay buen troughput el cliente pide la version 4k cuando hay malo se conformará con 144p. En cada HTTP GET puede elegir el chunk.

El servidor HTTP tiene un manifest file donde indica las URL de cada video con su bitrate. Primero el cliente pide el manifest file y mira las versiones. Luego pide un chunk por vez y corre un algoritmo para determinar cual chunk sera pedido la próxima vez (toma en cuenta el throughput y el video que ya hay buffereado). Lo que se quiere evitar es siempre la interrupción del video.

Content Distribution Networks (CDN)

Los datos pesados como imágenes y videos realmente son una carga para la red. Las compañías para mejorar la performance y poder distribuir esta cantidad masiva de datos utilizan content delivery networks (CDN). Un CDN tiene muchos servidores en todo el mundo con copia de objetos en sus servidores, cada request que recibe la trata de redirigir al servidor que le va a dar una mejor experiencia al usuario. Las CDN pueden ser privadas (google) o de terceros (le pagas a ellos, también son privadas en en ámbito del derecho publico). Existen dos filosofías para las CDN

- Enter Deep: Básicamente poner nodos por todas las isp posibles, muchos servidores y clusters por el mundo.

- Bring home: Poner los clusters donde importan, las isp van a venir. Se ponen los clusters en IXP y lugares para que las ISP se conecten.

Las CDN tienden a replicar su contenido entre losclusters. Sin embargo, no tiene por que querer una copia de cada video que casi nadie vaa mirar. Para ello usan una pull strategy: Si un cliente pide un video a un cluster que no tiene el video, el cluster consigue el video y se guarda una copia de este mientras lo streamea al cliente. Cuando se queda sin espacio se deshace de videos.

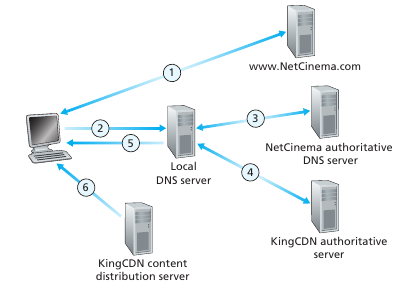

CDN Operation

Cuando un host pide un video (URL), la CDN tiene que interceptar la request para determinar el cluster CDN apropiado para ese cliente y redirigir el cliente a un servidor del cluster. Como es esto de interceptar? Las CDNs toman ventaja del DNS para hacer esta interceptación. Básicamente al pedir por un hostname, al llegar al dns authoritative lo que hace es darle la ip devuelve el hostname de uno de los servidores de la CDN al Local DNS. Entonces la LDNS hace el DNS query al CDN y luego este le da la ip de un servidor seleccionado por este. Finalmente el LDNS le devuelve la cdn al host. La secuencia de llamadas se muestra en la siguiente imagen:

Cluster Selection

Para elegir el mejor servidor de un cluster se emplean diversas estrategias. Desde geographically closest, la cual tiene la contra de que no siempre el que esta más cerca tiene el network path más cercano. Y real-time measurements donde los CDN envían "sondas" a los LDNS del mundo, para testear la velociad de conexión. El problema es que muchos LDNS están configurados para no responder a ninguna sonda (Las sondas que llegaron nunca volvieron...)

Socket Programming

En el desarrollo de aplicaciones existen dos tipos: Las que sus protocolos están especificados en un standard abierto (RFC) y las aplicaciones en red propietarias, que usan sus propio protocolos que no son públicos. Una de las primeras decisiones que debe tomar un desarrollador es si su app va utilizar TCP o UDP.

Socket programming in UDP

Consideraciones:

- Antes de enviar un mensaje por un socket, se tiene que agregar la dirección de destino del paquete. Esto es: La dirección IP del destino y el puerto (ya que varias aplicaciones pueden estar corriendo en el servidor). También se agrega el IP address y el puerto de quien envía el paquete aunque esto no lo hace explicitamente el programador pero el sistema operativo.

Ejemplo:

UDPClient.py:

from socket import *

serverName = ’hostname’

serverPort = 12000

clientSocket = socket(AF_INET, SOCK_DGRAM)

message = raw_input(’Input lowercase sentence:’)

clientSocket.sendto(message.encode(),(serverName, serverPort))

modifiedMessage, serverAddress = clientSocket.recvfrom(2048)

print(modifiedMessage.decode())

clientSocket.close()

observar que se crea un objeto "socket". El parametro AF_INET indica que se usará la red ipv4 y SOCK_DGRAM que el protocolo será UDP. No se elige el numero de socket. El sistema operativo nos asigna uno disponible. Observar como el sendTo del socket toma tanto el mensaje y la dirección. Esto es todo lo necesario para establecer una comunicación. recvFrom espera a que llegue un paquete al socket. Finalmente se libera el socket.

UDPServer.py:

from socket import *

serverPort = 12000

serverSocket = socket(AF_INET, SOCK_DGRAM)

serverSocket.bind((’’, serverPort))

print(”The server is ready to receive”)

while True:

message, clientAddress = serverSocket.recvfrom(2048)

modifiedMessage = message.decode().upper()

serverSocket.sendto(modifiedMessage.encode(), clientAddress)

La diferencia notable es que al socket se le hace un binding del puerto que queremos. Se asigna un puerto de manera explicita.

Socket programming in TCP

Unlike UDP, TCP is a connection-oriented protocol. This means that before the client and server can start to send data to each other, they first need to handshake and establish a TCP connection.

Al crear la conexión TCP nos asociamos los puerto,ip del servidor cliente. Luego tras establecer la conexión ambos lados pueden tirar paquetes al stream por el socket. Esto es diferente a la forma de pensar en mensajes.

Para crear una conexión TCP el servidor tiene que estar listo. Es decir debe estar corriendo antes que el cliente, que es el que inicia el handshake, pida la conexión. Además el servidor tiene que tener un socket especial para darle la bienvenida al host. El cliente se comunica con este socket para iniciar el handshake. Cuando el servidor recibe el primer handshake crea un nuevo socket dedicado al cliente que inicio el handshake. Este nuevo socket es la tubería que nos permite acceder al stream. Es importante notar que hay dos sockets del lado del servidor. El welcoming socket y el del stream (el cual es único para cada cliente). El cliente tiene un solo socket.

TCPCLient.py:

from socket import *

serverName = ’servername’

serverPort = 12000

clientSocket = socket(AF_INET, SOCK_STREAM)

clientSocket.connect((serverName,serverPort))

sentence = raw_input(’Input lowercase sentence:’)

clientSocket.send(sentence.encode())

modifiedSentence = clientSocket.recv(1024)

print(’From Server: ’, modifiedSentence.decode())

clientSocket.close()

Observar que ahora se usa SOCK_STREAM para crear el socket, esto indica que es TCP. El SO se encarga de asignar el puerto. el socket.connect es el que inicia la conexión TCP. Notar que el send no recibe la dirección, el programa simplemente tira los bytes en el socket. No hay mensajes. Luego el socket del cliente se cierra (le avisa al servidor que va a cerrar la conexión TCP).

TCPServer.py:

from socket import *

serverPort = 12000

serverSocket = socket(AF_INET,SOCK_STREAM)

serverSocket.bind((’’,serverPort))

serverSocket.listen(1)

print(’The server is ready to receive’)

while True:

connectionSocket, addr = serverSocket.accept()

sentence = connectionSocket.recv(1024).decode()

capitalizedSentence = sentence.upper()

connectionSocket.send(capitalizedSentence.encode())

connectionSocket.close()

aquí serverSocket es el welcoming socket y connectionSocket es el del stream. Notar como el welcoming socket ejecuta listen. El cual hace que se quede esperando a que alguien toque la puerta. (el parametro especifica el maximo de conexiones encoladas (hmm)). Cuando un cliente toca la puerta el servidor invoca accept() y crea el nuevo socket dedicado al cliente. Se completa el handshaking y el stream queda establecido. Luego se cierra el socket.

Parte III - Transport Layer

La función clave de la capa de transporte es: Extender el servicio de delivery de la capa de red entre dos sistemas finales a un servicio entre dos procesos de la capa de aplicación corriendo en dos sistemas finales.

Adicionalmente, se trata sobre los distintos servicios que pueden ofrecer este sistema. Siempre recordando que los servicio que pueden proveer están limitados por los servicios de las capas de abajo. Si la capa de red no ofrece minimos delays, la capa de transporte tampoco. Sin embargo, existen servios que puede proveer utilizando compleja ingenieria: Como control de congestion, y connection reliability. Recordar que si bien es la capa de transporte la que provee estos servicios, cualquier otra capa lo pudiese haber hecho. Los protocolos de congestion de TCP son un tema de estudio, estos evolucionan a lo largo de los años. UDP y TCP son los caballos de batalla de la internet, pero han estado surgiendo otros protocolos en los últimos años:

DCCP (data congestion control protocol): low-overhead, message-oriented, UDP-like unreliable service. Pero con un sistema de congestion compatible con TCP.

QUIC (Quick UDP Internet Connections) Protocol : provides reliability via retransmission as well as error correction, fast connection setup and rate based congestion control algorithm aiming to be TCP friendly. Todo esto implementado como un application level protocol sobre UDP.

DCTCP (Data Center TCP): Version de TCP diseñada para redes de datacenters.

SCTP (Stream Control Transmission Protocol). Reliable message-oriented protocol that allows several different application-level "streams" to be multiplexed through a single SCTP connections. Implementa funcionalidades adicionales como multi-stream opt in out-of-order-data, etc/

TFRC (TCP Friendly Rate Control) Protocol. Protocolo de congestion solamente (como DCCP), tiene como objetivo ser más smooth que TCP en cuanto al control del sending rate.

Intro and Transport-Layer Services

Un transport protocol provee comunicación lógica entre dos procesos de aplicación en distintos hosts. Esto es, los host corren procesos como si estuviesen directamente conectados (ignoran por todos los routers que deben pasar). Los protocolos de transporte se implementan en los sistemas finales. Al enviar paquetes, la capa de transporte convierte los mensajes de las aplicaciones en paquetes de la capa de transporte llamados segmentos. Por lo general se parte el mensaje en pequeños paquetes para generar estos segmentos. Luego la capa de transporte le pasa estos segmentos a la capa de red del mismo host (encapsulando este segmento en un datagrama) para transportar los segmentos al host final - desde el protocolo de red.

Mientras que el transport layer procesa la comunicación lógica entre procesos. corriendo en distintos hosts, la capa de red provee comunicación lógica entre hosts. El libro usa una based analogy de 2 casas con niños que se mandan cartas. Las mamás de cada casa levantan las cartas de los niños y se las mandan al correo postal, a su vez levantan las cartas que el correo postal dejó para su casa, y se las da a los respectivos niños destinatarios. Para los niños, la mamá es todo el sistema de transporte de cartas, no conocen el servicio postal. A su vez, distintas mamás pueden ser distintas, algunas pueden llevar la cuenta de las cartas que envían y avisarle a sus hijos que su amigo recibió todas, mientras que otras solamente mandan la carta y poco le importa si llega bien o no. Por otro lado las madres están limitadas por el servicio postal, si el servicio postal no puede prometer que las cartas se envíen en menos de 3 días, ellas tampoco.

En internet tenemos dos grandes: TCP y UDP. Cabe destacar que si bien los transport layer packets son segments y los network layer packets son datagrams, en las RFC se usa datagram para los paquetes UDP (Para tener en consideración).

IP es el protocolo de red que provee comunicación lógica entre los hosts. El modelo de servicio IP se le llama best-effort delivery service, ya que hace lo mejor que puede pero no ofrece ninguna garantía: Los paquetes pueden nunca llegar, pueden alterarse (integridad) e incluso llegar en distinto orden. En este sentido el protocolo IP es un unreliable service. Muchos protoclos de trasporte tratan de enmendar esto, o mejor dicho, dar servicios adicionales.

La funcionaliad clave del protocolo de transporte: Extender host-to-host delivery -> process-to-process delivery se le llama transport layer multiplexing/demultiplexing.

Multiplexing & Demultiplexing

Cuando estamos en zoom y miramos un video de youtube, nos llegan paquetes (host) de parte de varias aplicaciones, es responsabilidad del transport protocol enviarselos al proceso correspondiente. Para llevar esto a cabo se usan sockets. Por lo tanto, el protocolo de transporte no envía los mensajes directamente al proceso pero a un socket que esta asignado a uno.

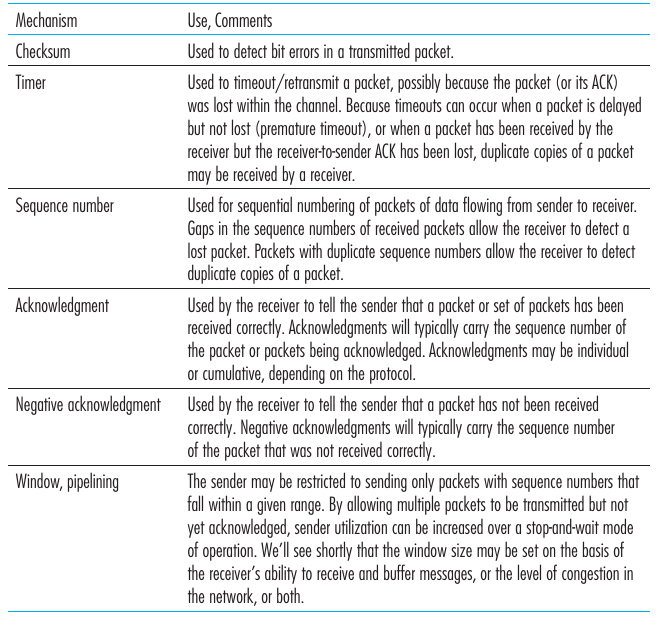

Se le llama demultiplexing al trabajo de enviar los datos de un segmento al socket correcto. El trabajo de juntar chunks de datos, encapsularlos ( agregarle información (ej. socket destino) transformarlos en segmentos) y envíarlos al network-layer para que viajen se le llama multiplexing. Para hacer este trabajo se necesitan dos piezas esenciales:

- Los sockets deben tener un identificador único (o por lo menos una forma de)

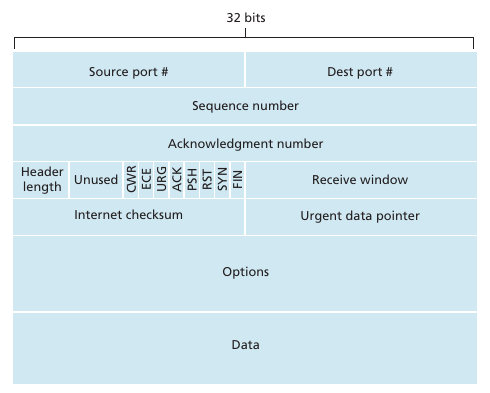

- Cada segmento debe tener información relativa al socket al cual debe ser envíado. (Esto es Source port number field y le Destination port number field. )

Un puerto en un host se identifica con un 16ibt number (0-65535). Los puertos del 0 al 1023 se les conoce como well-known port numbers y están restringidos a protocolos conocidos. (EJ: HTTP 80, FTP 21, etc.). Notar que $puerto \neq socket$ . Mientras que un socket es una estructura para que un proceso reciba/envíe mensajes, un puerto es simplemente un número que potencialmente puede identificar a un socket. A su vez los sockets dependen del protocolo de transporte: No es lo mismo el TCP port 80 que el UDP port 80.

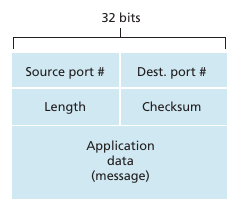

En un segmento UDP, se manda el source port, destination port y dos valores adicionales. Con esto queda determinado el socket. El source port se usa para que la aplicación que le llega el mensaje sepa a que puerto envíar un mensaje si desea responder. Para demultiplexar basta con mirar el destination port para saber a cual socket UDP envíar el segmento. Por lo tanto un socket UDP está definido de forma única por la tupla IP dest Address y Destintation Port.

Por otro lado, en TCP un socket queda definido por una 4-upla: $< source\ IP\ address,\ source\ port\ number,\ destination\ IP\ address,\ destination\ port\ number>$ . De esta forma tenemos dos sockets diferentes para dos hosts que hablan con el puerto 80 de un webserver. La excepción de esto se da en los primeros segmentos TCP que contienen el pedido original de conexión. Cuando un servidor receive un incoming connection-request segmento en un cierto puerto, este localiza los procesos que estas esperando para aceptar una conexión en dicho puerto, luego de aceptarla se crea un nuevo socket que establece un túnel de comunicación entre ambas partes.

Nmap es una utilidad que nos permite ver los puertos abiertos/cerrados y deshabilitados de un host de internet. Los puertos abiertos son necesarios para enviar menajes por internet, pero son una puerta de acceso rapido a un sistema y atacarlo si se puede acceder desde un puerto a aplicaciones vulnerables.

Connectionless Transport: UDP

UDP hace casi lo minimo indispensable para implementar un protocolo de transporte: Multiplex/Demultiplex and a little error checking. UDP se le conoce como connectionless ya que no hay handshaking, son puramente mensajes que se envían de un puerto a otro. Una aplicación que utiliza UDP, cuando envía un mensaje y no recibe un mensaje tras cierto tiempo, puede hacer lo siguiente: Reenviar el mensaje, probar otro host (si aplica), avisar que no tuvo éxito. Ahora bien, si TCP es confiable para que existe UDP?? Hay aplicaciones en las que UDP is better suited for the following reasons:

Finer application-level control over what data is sent, and when: Al enviar un mensaje con UDP, UDP empaqueta el mensaje en un segmento UDP y se lo manda de una al network layer. TCP por otro lado hace control de congestión y renvía los segmentos hasta que el que los recibe haga un acknowledge. Muchas aplicaciones en tiempo real quieren un sending rate minimo (que no los frenen), que no haya casi delays y toleran que se pierdan datos. Para estas aplicaciones UDP cubre mejor sus necesidades que TCP.

No connection establishment: El three-way handshake produce un delay muchas veces indeseable. Por ejemplo, el servicio DNS sería mucho mas lento si usara TCP (con UDP es tan solo dos paquetes que viajan!). En la Web se usa TCP para no perder información, pero incluso se están creando protoclos como QUIC que usan UDP e implementan la reliability por encima de UDP.

No connection state: TCP requiere almacenar variables por cada conexión: buffers, congestion-control parameters, sequence and ack parameters, etc. UDP no mantiene ningún estado ni seguimiento de parametros. Por lo tanto un servidor puede tener muchos mas clientes activos por UDP que TCP.

Menor overhead en el header del paquete: Un segmento TCP tiene un header de 20 bytes por cada segmento. Mientras que uno UDP tiene tan solo 8 bytes. Wow!

Según Kurose, UDP es un protocolo controversial, ya que no tiene control de congestion y el uso de UDP está en detrimento de las conexiones TCP cuando la red está saturada. Por ello, el uso de UDP en realidad no contribuye pero empeora el esfuerzo de mantener la red saludable. Incluso peor es el hecho de que no es necesario TCP para tener una aplicación con transmisión de datos confiable si este implementa sus controles por encima de UDP (QUIC), resultando en protoclos con las ventajas de UDP pero con la reliability de TCP.

UDP Segment Structure

Se necesita un length field ya que el tamaño del campo data es variable. La checksum se utiliza para verificar que no se introdujeron errores en el segmento. En length field incluye el tamaño del header. El checksum se realiza haciendo el 1s complement de la suma de todas las 16bit words del segmento. UDP implementa corrección de errores a pesar de que capas más abajo lo implementan (ej ethernet) ya que nada asegura que no haya algún link sin error-checking. Esto es un caso del end-to-end principle el cual indica que ciertas funcionalidades (corrección de errores) deben ser implementadas en una end-end basis. Recordar que UDP no hace nada para recuperarse en el caso de que la checksum de mal. Simplemente no hace nada o le envía una warning a la aplicación.

Functions placed at the lower levels may be redundant or of little value when compared to the cost of providing them at the higher level.

Principles of Reliable Data Transfer

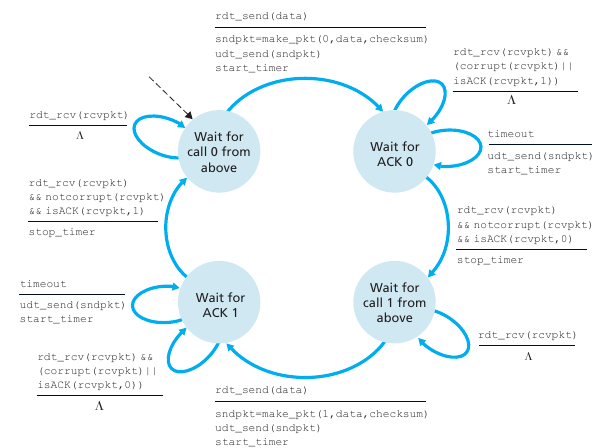

Como podemos implementar un reliable data transfer protocol? En el libro se hace un proceso incremental de una maquina de estados hasta un protocolo que soporta pipelining.

La siguiente maquina de estados muestra un protocolo que implementa reliable data transfers. Los paquetes pueden corromperse y nunca llegar y esto no sería un problema. La lógica del mismo es:

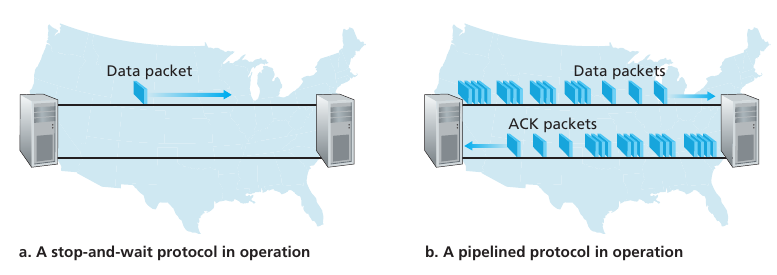

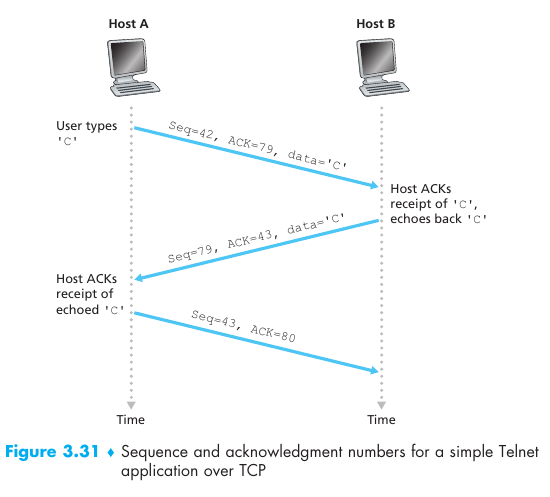

Mando un paquete con secuencia 0. Espero que me llegue un ACK de la secuencia 0 y setteo un timer. Si me llega algo corrupto o de otra secuencia no hago nada. Si se da timeout reenvío el paquete. Si me llega el ACK del seq 0 paro el timer y queda confirmo que el paquete que envié llegó a su destino :^).